[转贴] 瀚博半导体推首款云端AI推理芯片,INT8峰值算力超200 TOPS

Tan KW

Publish date: Wed, 07 Jul 2021, 02:36 PM

芯东西(公众号:aichip001)

作者 | 心缘

编辑 | 漠影

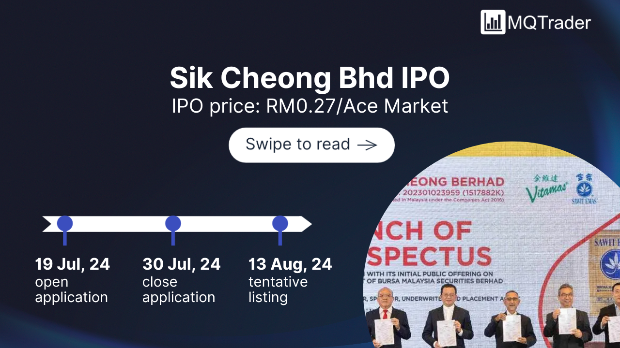

芯东西7月7日报道,在2021世界人工智能大会上,瀚博半导体推出其首款云端AI通用推理芯片SV100系列,以及通用AI推理加速卡VA1。

瀚博半导体创始人兼CEO钱军说,这两款新品能有效应对低延时、通用性和视频处理等方面的行业痛点,推进云端与边缘的智能应用落地。

据悉,其SV100系列首发产品SV102现与国内外多家头部互联网公司合作,预计将于今年第四季度量产上市。

瀚博半导体成立于2018年12月,总部设在上海,在北京、深圳和多伦多有研发分部。当前其团队规模已超过200人,硕士及以上学历占80%。今年2月,瀚博研究院成立。

融资进展方面,瀚博半导体先是在2019年3月获得真格基金天使轮融资,2019年6月获得天狼星、耀途Pre-A轮融资,去年7月获得快手、五源、红点、赛富A轮融资5000万美元,今年3月获得中国互联网投资基金、经纬中国、联发科5亿元A+轮融资。

▲瀚博半导体创始人兼CEO钱军展示SV100系列芯片

▲瀚博半导体创始人兼CEO钱军展示SV100系列芯片

一、核心团队拥有超15年芯片经验,曾参与业界首款7nm GPU流片

瀚博半导体的两位创始人,CEO钱军和CTO张磊,都拥有20多年的芯片设计经验,并均在创业前曾任AMD高管,深度了解行业客户对吞吐量、延迟、通用性和成本的需求。

据钱军分享,瀚博的核心员工拥有超过15年的GPU相关芯片及软件设计经验,包括业界第一颗7nm GPU在内的约100款芯片流片、量产经验。

不过,不同于核心团队以往的研发方向,瀚博半导体没有选择继续深耕GPU赛道,转而研发针对各种深度学习推理负载进行优化的DSA架构。

钱军引用了一些行业数据,AI进入应用期,数据中心推理算力需求的复合增长率是训练的2倍以上,2021年中国市场AI服务器的推理负载有望超过训练负载。在推理侧,GPU不是最好的解决方案,性能不及DSA架构。基于这些原因,瀚博半导体选择首先研发基于DSA架构的推理芯片。

钱军将AI推理计算的核心性能指标总结为LTE:延时(latency)、吞吐量(Throughput)、能效(Energy Efficiency)。

对此,瀚博半导体的应对之道是在视频处理方面,让高并发的解码能力与AI算力匹配;在LTE方面,具备极低延时、极高吞吐量性能,并保持低功耗;在创新方面,提供负载分析、硬件通用可扩展、软件栈。

二、首款云端推理芯片,峰值算力超200 TOPS

自成立起,瀚博半导体即启动自研AI核,随后在2020年5月实现其首颗半定制7nm芯片的流片。今天,瀚博半导体正式发布其首款云端AI通用推理芯片SV100系列。

瀚博SV100系列是一款超高性能人工智能与视频处理芯片,核心优势是能兼顾智能视频解码和AI计算的需求。2021年6月,SV100系列芯片测试成功。钱军透露说,这款推理芯片开始测试8分钟就宣布点亮。

瀚博SV100单芯片INT8峰值算力超200 TOPS。相同功耗下,SV100可实现数倍于现有主流数据中心GPU的深度学习推理性能指标,具有超高吞吐率、超低延时的特性。

SV100基于瀚博自主研发的通用DSA架构,支持FP16、BF16和INT8等数据格式,可实现众多主流神经网络的快速部署,适用于计算机视觉、智能视频处理、自然语言处理和搜索推荐等多种推理应用场景。

同时,SV100系列集成高达64路以上H.264/H.265/AVS2的1080p视频解码,广泛适用于云端与边缘智能应用场景,能帮助客户节省设备投资、降低运营成本。

三、VA1:同等能耗下,AI吞吐率最高达GPU的10倍

除了发布SV100系列,瀚博半导体也同步推出了基于SV102芯片(SV100系列首发产品)的VA1 PCIe推理加速卡。

VA1采用单宽半高半长75瓦PCIe x16卡设计,支持32GB内存和PCIe 4.0高速接口协议,适用于绝大多数服务器,无需额外供电,即可实现数据中心高密度算力部署。

该加速卡可提供高效率深度学习AI推理加速,在同等能耗下,实现2-10倍于GPU的最高AI吞吐率,而延时不到GPU的5%,适合实时应用。

同时,它兼备良好的通用性和可扩展性,支持FP16、BF16和INT8数据类型的主流神经网络快速部署,包括检测、分类、识别、分割,视频处理、LSTM/RNN、NLP/BERT、搜索推荐等。

如下图所示,同为75瓦功耗时,在处理两种AI模型时,瀚博VA1吞吐率均超过了英伟达的A10和T4云端推理GPU。

根据瀚博半导体分享的测试结果,同等推理性能下,瀚博SV102/VA1方案比英伟达T4 GPU节省60%服务器成本,比A10 GPU节省50%的TCO。

视频处理方面,VA1支持64路以上H264、H265或AVS2 1080p解码,分辨率支持高达8K。

相比之下,市面上许多云端AI推理芯片没有内置视频解码,而是用多个GPU来做视频解码,因此从更适配处理到AI加速要用到多颗芯片,而VA1只用一颗SV102就能兼顾两类功能,且功耗更低、处理能力更强。

目前,瀚博半导体正将其加速卡与联想、浪潮、新华三、超微服务器以及CentOS、Ubuntu、红帽、中标麒麟、银河麒麟等操作系统做适配。

钱军透露说,瀚博半导体后续还会推出15W、150W的产品。

四、高度灵活软件栈,支持自定义算子扩展

考虑到向前兼容性非常重要,瀚博半导体的软件栈具有极高灵活性与可扩展性,能够支持未来新兴算法模型和用户自定义算子扩展等。

另一方面,占据过半中国AI应用市场的计算机视觉应用,需要高密度的视频解码算力配合AI算力实现端到端的计算加速,在两者之间的算力配比平衡方面,瀚博半导体也做了大量的工作。

瀚博半导体创始人兼CTO张磊说:“我们的软件栈完备,同时提供了符合行业开发者使用习惯的工具,方便使用者以极低成本向瀚博硬件平台迁移、部署现有算法应用。”

目前瀚博半导体的VastStream软件平台已支持TensorFlow、PyTorch、Caffe2等主流深度学习框架模型与ONNX格式的模型,通过高度定制的AI编译器充分优化模型在瀚博硬件上的执行效率。

结语:国产云端AI芯片队伍日益壮大

随着瀚博半导体推出其SV100系列芯片,国产云端AI芯片的队伍迎来又一位新成员。

AI芯片赛道持续火热,资本投资热情不减。不过与前两年不同的是,如今人们看待AI芯片更加理性,不再轻易听信故事,而是聚焦在审视其核心技术的独特竞争优势以及落地能力上。

如今全球AI芯片仍在起步阶段,无论是科研创新还是产业应用都有广阔的探索空间。对于AI芯片创企来说,这仍是个开创未来的黄金时代。

https://zhidx.com/p/281181.html

More articles on Future Tech

Created by Tan KW | Aug 11, 2024

Created by Tan KW | Aug 11, 2024

Created by Tan KW | Aug 10, 2024